民主允許人民擁有政治自由和言論自由,提供人們尋求真相的機制和教育,可以揭開當前或歷史事件背後扭曲、歪曲、意識形態和階級利益的面紗下隱藏的真相。因此,享有的獨特「智識」特權,知識份子的責任深遠。

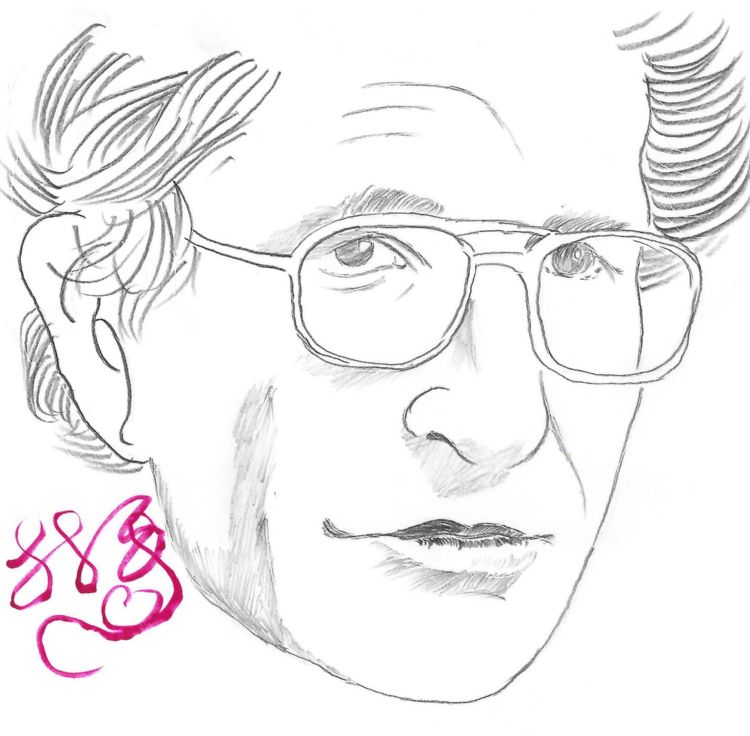

語言學家和哲學家杭士基(Avram Noam Chomsky)指出:「知識份子有責任講真話,揭露謊言。」這句話強調具有知識和理解力的人士在倫理上有責任傳播準確的信息,並揭露虛假。今日,人工智慧(AI)成為一種強大的工具,與這種責任相契合,它提供了前所未有的能力,既能揭露又能對抗錯誤信息。

AI在驗證信息和檢測虛假方面有其威力。人類利用機器學習算法,可以分析大量數據,將主張與已確立的事實交叉參照,以驗證其準確性,提供超出人類能力範圍的洞察。例如,Facebook和X等平台使用AI來檢測和標記虛假信息。AI能夠迅速揭穿在社交媒體和其他平台上流傳的虛假主張,有效遏制錯誤信息的傳播。

AI在對抗Deepfake(使用AI創建的高度逼真但虛假的音頻和影片內容)方面也發揮重要作用。先進的AI模型通過分析人類無法察覺的微小不一致性來檢測Deepfake,保持信息的完整性,防止操縱內容的傳播。例如,微軟(Microsoft)開發的Video Authenticator工具能夠分析視訊中畫素的細微變化,檢測出Deepfake,從而維護信息的真實性。

隨著生成式AI的快速進步,單純的偵測已成為一場永無止境的競賽。

為此,微軟等業界領導者已將策略從被動偵測,升級為主動建立信任的「來源證明」(Provenance)架構。他們共同發起「內容來源與真實性聯盟」(C2PA),並推動「內容憑證」(Content Credentials)技術標準。這個標準如同數位內容的「營養標籤」,可以在檔案中嵌入其來源、作者及編輯歷史,讓使用者能輕鬆查驗資訊的真實性。

今日大語言模型(LLM)的聊天應用貪婪地吞噬巨量的數據,在對話中找到最合理的答案,或是在科學問題中找到最有可能的解答。杭士基認為LLM「基本上是一種比較高科技的剽竊」和「逃避學習的方式」。人類的心智不像LLM,而是一個更驚人、有效率又優雅的系統,僅用有限的資訊就能運作。它不會試圖從數據中找出關聯性,而是努力創造解釋,分辨是非。

要達到杭士基的理想,AI應該朝說真話和揭露謊言方面整合,賦予深遠的社會意義。AI應增強知識份子有效履行職責的能力,確保準確信息在公共領域中傳播。隨著AI的不斷進化,它在保持信息完整性方面的角色將變得日益重要。特別是在政治選舉和公共衛生等關鍵領域,AI可以幫助確保信息的透明和準確,保護民主進程和公共利益。

然而,使用AI尋求真相,開發人員必須確保AI系統的公正透明,避免傳播虛假信息或不公正的結果。例如,AI算法在訓練數據上的偏見可能導致不公平的結果,必須有嚴格的審查和調整。我們必須設置監管架構來監督AI在信息傳播中的使用,平衡其潛在的好處與倫理考慮。社會必須對AI的潛在濫用保持警惕。

技術人員、倫理學家和政策制定者之間必須持續的對話,負責任地使用AI,創造一個真理繁榮且虛假最小化的環境。因此,未來的發展需以品德教育為首,確保AI服務於真理和正義,達成杭士基對知識份子責任的願景。