記憶體大廠CES大秀HBM實力 AI、雲端、高速傳輸新品動能備出

記憶體產業復甦跡象明確,AI浪潮快速興起,各家記憶體大廠積極掌握先進製程商機作為成長動能,隨著記憶體成為雲端伺服器及AI終端應用不可或缺的要角。

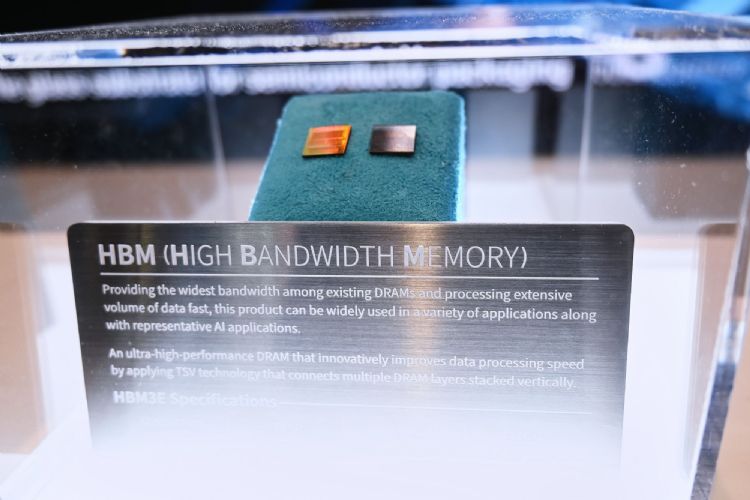

此次2024年CES期間的各大記憶體廠均以AI為聚焦重心,HBM、高速傳輸等新品呈現百花齊放,率先搶攻記憶體從谷底翻身的成長契機。

儘管各大記憶體廠仍背負營運虧損的壓力,但生成式AI採用高頻寬記憶體(HBM)推動價格倍速翻漲,讓記憶體產業從過去標準化的量產規模競爭,走向客製化的高技術含量競爭。

近期市場傳出,大客戶NVIDIA提前支付數億美元預付款給SK海力士(SK Hynix)、美光(Micron),以確保2024年AI GPU搭配HBM3E的供貨穩定,並降低記憶體業者財務及投資的壓力。

尤其以SK海力士2023年已在HBM領域搶先攻下一城,取得全球市佔逾5成的領導地位,而三星電子(Samsung Electronics)也緊追在後。

據傳,HBM3、HBM3E陸續結束產品測試,可望與NVIDIA簽訂供應合約,兩家韓系記憶體廠不僅在HBM互別苗頭,交鋒戰場延伸至CES展會,並擴大戰線至雲端伺服器的記憶體介面CXL(Compute Express Link)的布局。

SK海力士在CES展示了HBM3E,號稱是業界最高的每秒1.18 TB的資料處理速度,滿足AI市場在快速處理海量資料的需求,與前一代產品相比,速度將提高了1.3倍,資料容量也提高1.4 倍,獨家開發的MR-MUF技術更是SK海力士的強調重點,提升散熱性能約10%。

SK海力士預計將於2024年上半年量產HBM3E,至於CXL透過擴展記憶體和提高AI應用性能受到關注,預計在AI時代下將與HBM3E發揮相乘的關鍵效益。

三星針對生成式AI的DRAM方案有三大領域,分別為12奈米32 Gb DDR5 DRAM、HBM3E以及CXL記憶體模組產品。

其中,32Gb DDR5 DRAM 是目前單晶片容量最大的DRAM產品,而CXL介面雖然過去推動多年,但AI商機帶來新機會,三星認為,透過在伺服器前端安裝CXL介面的模組產品,將能大幅增加每台伺服器的記憶體容量,將適合用於處理大量資料的生成式AI平台。

隨著生成式AI應用逐漸地從雲端資料中心擴展至終端邊緣裝置,內建AI功能的PC將在2024年先後登場推出,美光在CES展出的LPCAMM2記憶體被視為AI PC的最後一哩路,採用LPDDR5X DRAM,但更強調降低功耗及節省空間。

美光強調,LPCAMM2已開始送樣,預計於2024年上半年量產,將導入多家PC大廠的筆電新品。

不僅三大記憶體廠在CES大打AI商機,台廠鈺創也在CES首度亮相4Gb DDR3 LRTDRAMTM(Long Retention Time Dynamic Random-Access Memory),鎖定在AI應用、KGD異質整合封裝、車載等高溫應用情境的創新型記憶體,以獨家首創的長效資料保存技術為重點訴求。

由於AI應用在高速運算的需求下,傳統DRAM受限於先天物理特性,存取效能會隨著溫度上升而衰減。鈺創表示,4Gb DDR3 LRTDRAM可在攝氏122度的高溫下達到超過104毫秒的100%長時保留,目前4Gb DDR3 LRTDRAM相關驗證已經完成,並開始送樣給客戶。

責任編輯:陳奭璁